Joint Future Work[1] und Fehlermöglichkeiten in der Digitalisierung:

Teil 1: Business Intelligence: Die Datenbasis muss stimmen!

Jedes Organisationsprojekt hängt in seinem endgültigen Erfolg im Wesentlichen an einem einzigen Umstand: habe ich zu Beginn alle notwendigen, hinreichenden und verifizierbaren Daten und Informationen, also eine valide Datenbasis des IST-Zustandes, um daraus das zu erreichende SOLL, definieren und herstellen zu können? Ist dieser Punkt schon fehlerhaft, bin ich ggf. schon nicht in der Lage, meine IST-Situation exakt genug zu bestimmen. Die Annahme, dass sich das im Laufe des Projektes verbessert, ist an sich schon falsch, denn wer vom falschen Punkt aus startet, kann sein Ziel nicht klar genug erkennen – mitunter auch nicht mehr erreichen. Mit der Lösung loszulegen und unterwegs den Weg zu suchen, ist etwas, was schon viele, gerade langjährige Projekte, schnell zum Talergrab hat werden lassen. Beispiele stehen in Hamburg an der Elbe und nahe Berlin.

Projekte wie Kolumbus:

“Als wir loslegten, wussten wir nicht wohin wir wollten, als wir ankamen, wussten wir nichts davon und als wir zurückkamen, konnten wir keinem sagen, wo wir waren…”

Ein Projekt, das fast jeden berührte, war SEPA. Spätestens hier wurde für viele deutlich, dass SEPA eben kein IT-Projekt war, das Kontonummer und Bankleitzahl gegen IBAN und BIC austauschte und eine Mandatsnummer hinzufügte. Zuzüglich ein wenig Prenotification-Papierkram für die Buchhaltung.Obwohl rechtzeitig gewarnt glaubten viele, das Projekt nebenher und recht spät starten zu können [2]. Der Fehler kostete viele Unternehmen “große lila Scheinchen” zusätzlich und führte zu einer fast fünfmonatigen Verzögerung bei der europaweiten Einführung. Eine große Versicherung schaffte es sogar fast drei Tage offline gehen zu können.

Die Mandatsdatenbank, das Kernstück von SEPA, war die Herausforderung. Es wurde schnell deutlich, dass viele Unternehmen nicht ihre Prozesse genau genug kannten, um zu wissen, von wo welche Daten durch welche Stelle wann wo abgerufen und / oder nach Veränderung wieder eingesteuert wurden, um die nötige Validität zu haben, dass am Ende das Mandat nicht zurückkommt. Datenmanagement in oft nur schlecht verstandener Vollendung.

SEPA war mitnichten ein klassisches IT-Projekt. Es war ein Organisationsprojekt, das erst dann, nach umfangreicher Vorbereitung, in der IT laufen konnte. Doch dazu mussten die dort bereitgestellten Schnittstellen organisatorisch verifizierbar und valide befüllt und verbunden werden. Das war schwerer und zeitaufwendiger als gedacht. Nicht weil es das tatsächlich war, sondern weil man mit dem falschen Projekt-Fokus an das Problem herangegangen war, seine Prozesse nicht genau genug kannte, um den (Wahrnehmungs-)Fehler überhaupt zu sehen; und weil mitunter dadurch die wirklich fachlich relevanten Abteilungen zu spät eingebunden wurden und in Zeitdruck gerieten. Exakt das ist das Problem, mit der sich die Business Intelligence (BI) schon seit ihrer ersten – damals eher visionären – fachlichen Definition in der Wirtschaft herumschlägt.

Ende der 90er gab es Bestrebungen aus dem angloamerikanischen Raum heraus, die in allen Unternehmen reichlich verfügbaren Daten besser zu nutzen. Überall gab es nun flächendeckend eine IT, und die zunehmend global arbeitende Wirtschaft konnte immense Kosteneinsparungen generieren, wenn Planung, Kontrolle und Waren- wie auch Kapitalflüsse besser und möglichst “just-in-time” (aus damaliger Sicht: relativ zeitnah) in Reports “kommunizierbar” und damit auswertbar und für Entscheidungen verfügbar wären.

Der gesamte Ansatz wurde dem Military Intelligence entnommen, der darauf basierte, die nachrichtendienstlichen und fernmeldetechnischen Ergebnisse aus der Aufklärung aller Bereiche, ebenengerecht konsolidiert, ausgewertet, beurteilt und mit Handlungsempfehlungen versehen, der Führung zeitnah als valides Lagebild oder als Führungsinformation zugänglich zu machen.

Es wurde schnell deutlich, dass der industrielle Ansatz sehr schwierig zu bewerkstelligen war, da es zwar überall IT gab, doch diese nur lokal vernetzt waren und der Datenaustausch in aller Regel über Excel-Schnittstellen / -files liefen. Die Bandbreite (und auch Verfügbarkeit) des Internets schuf weitere Grenzen. Erst mit einer wirklichen flächendeckenden Internetabdeckung und dem Data-Warehouse-Konzept gelang es, eine (mehr oder weniger) physikalisch zusammenhängende, hochverfügbare Datenbasis zu schaffen, die prozessual (!) valide Reports ermöglichte. Die heute üblichen webbasierenden Lösungen sind in etwa das, was man damals visionär wollte, aber technisch nicht hinbekommen konnte. Damals wurde allerdings schon ein Fehler sichtbar, der sich auch heute noch durch alle technischen Lösungen und durch nahezu alle Unternehmen zieht: global, interkulturell, multilingual, webverbreitet und damit nahezu unausrottbar: Excelitis!

Ist Excelitis eine Krankheit?

Nein. Eher eine Seuche. Und noch schwerer einzudämmen als eine solche, weil jeder in gutem Glauben handelt – und es daher schlimmer macht. Excelitis leitet sich namentlich aus der leidlich bekannten und überall verfügbaren MS-Excel-Software ab. Leidlich bekannt deshalb, da 90% der User nur 20% der Anwendungstiefe nutzen und noch weniger beherrschen. Und das macht letztlich das “überall verfügbar” noch schlimmer. Denn Excel beherrscht den zahlenbasierten Austausch von Kalkulationen, Statusreports und ist oft Grundlage für Datenübernahmen in ERP-Systeme, fast weltweit. Denken wir nur an die Darstellungsart “excel” bei SAP. Und damit nicht genug: Alle DOS-basierenden ERP-, BPM-, BI- und Spezialanwendungen, verknüpfen über ihr Programm eben diese Excel-Tabs miteinander.

Warum ist das eine Seuche?

Weil sich keiner ganzheitlich darüber Gedanken macht, was so alles eingestellt, verknüpft, verbunden, übermittelt und wie auch immer weiterverarbeitet wird. Auch ist das in aller Regel ein völlig undokumentierter Wust und damit auch mit undefinierter Basis, was Wertdefinitionen, Verknüfungsrichtlinien und Zuständigkeiten angeht. Oft ohne jedes Wissen, wer welche Daten, Werte oder Inhalte wie und wann wo verwendet. Ohne Wissen, wann welche Daten aktualisiert werden, die womöglich wo auch immer im Netz abgegriffen und weiterverarbeitet werden, solange der Zugriff nicht eingeschränkt ist. Damit besteht dann eine gute Chance, fehlerhafte oder nicht aktuelle Werte zyklisch zu verwenden. Und das ist nur die organisatorische Seite des Problems. Doch hinter jeder organisatorischen Fehlerquelle steht in aller Regel eine menschliche Dimension. Und diese hat mehrere Ausprägungen, die die Excelitis zusätzlich verstärken:

1.) Der Könner- der Experte – das Excelgenie

Dieser Typus beherrscht die Software wie sie die anderen 90% der User gerne beherrschen würden, es aber nie schaffen. Dieser Typus neigt dazu, jede auch noch so (un)nützliche, übersichtliche und verstandene Tabelle “zu perfektionieren”. Der dabei gültige Herangehensansatz ist sein von ihm selbst verordnetes Niveau, das leider nur selten bei anderen erreicht wird. Er schafft somit Konstrukte, die einem Kunstwerk ähneln, aber von anderen nicht mehr verstanden werden, auch wenn sich jeder über die Ergebnisse freut. Vorgesetzte neigen dazu, dieses Werk dann als “vorbildlich” zu bezeichnen und hinterfragen kaum noch die Relevanz hinsichtlich allgemeiner Mach- und Handhabbarkeit für andere. Auch neigen Genies in aller Regel dazu, die von ihnen eingebundenen Werte nur selten so weit zurückzuverfolgen, um sicherzustellen, dass sie valide sind. Das ist etwas für schwächere Geister, stört das kreative Werk an sich und “wird schon gutgehen”. Er schafft die Grundlage, den Nährboden der Seuche: das allgemeine (nur geflüsterte) Unverständnis, was er da eigentlich gemacht hat…

2.) Der Normaluser – Typ 1: bestrebt, mit Wissen um die eigenen Grenzen

Dieser Typus kennt seine Fähigkeiten recht genau und macht nur das, was er auch versteht. Er verbreitet Excel auf einer allgemein handhabbaren Weise. Seine Verknüpfungen und Konstrukte sind in aller Regel übersichtlich, leicht verständlich und schnell nachvollziehbar. Sein Spaß an neuen Kreationen hält sich in Grenzen. Er sieht Excel als Werkzeug an. Nicht als Lebensinhalt. Er ist der, der immer bestrebt ist, valide Daten zu erzeugen. Das Arbeitstier der Abteilung. Gut ausgelastet und daher auch nicht mehr in der Lage, alle Verknüpfungen, Pfade und logischen Ausdrücke vollumfänglich zu verifizieren. Er ist der, der in aller Regel auf Missstände aufmerksam macht und mit der Aussage abgespeist wird: “Ich weiß. Doch wenn das einer hinbekommt, dann Sie. – Ich habe da großes Vertrauen!” – Und dann war er vergessen. Und mit ihm der Grund des Gesprächs.

3.) Der Normaluser – Typ 2: bestrebt, Hang zur Selbstüberschätzung

Dieser Typus ist der Krankheitserreger schlechthin. Der Patient Null, den jeder Virologe bei Ausbruch sucht. Der “Seuchenvogel”! Derer gibt es viele. Und sie sind seit Jahrzehnten am Werk. Da, wo der Typus 1, Fehler ausmerzt, Verknüpfungen bereinigt und Validität schafft, da schafft es dieser Typus innerhalb sehr kurzer Zeit, den ursprünglichen Status Quo wiederherzustellen. Sein Vorbild sind die Kunstwerke der Genies, die er zu adaptieren – zu duplizieren – versucht. Oft mit durchschlagendem Misserfolg. Aber mit hoher Selbstmotivation es erneut zu versuchen.

4.) Der Normaluser – Typ 3: wenig bestrebt, “9-to-5?- Mitarbeiter

Dieser Mitarbeiter verbreitet alles und jedes, sobald er es mal bearbeitet hat. Werte auf Sinnhaftigkeit zu prüfen, Verknüpfungen zu hinterfragen und offensichtlich dümmliche Ergebnisse schocken ihn nicht. Das was kommt, muss richtig sein. Darauf kann man aufbauen. Fehler werden im Rahmen der eigenen Verantwortlichkeit korrigiert. Wenn Zeit und Möglichkeit auch in Zusammenarbeit mit anderen Prozessbeteiligten. Dieser User ist der Folgepatient in der Epidemie. Er trägt den Virus weiter. Die Excelitis breitet sich schlagartig aus. Er macht nach Schätzungen 60% der Beschäftigten im Unternehmen aus. Mitarbeiter, die schon innerlich gekündigt haben und nur noch erscheinen, weil sie das Geld brauchen. In Extremis ohne Interesse am Unternehmen, den Prozessen oder dem, was wird.

5.) Der Wenig- bis Garnichtuser

Hier sind die Berührungspunkte zu Excel sehr durch Vorsichtigkeit geprägt. Er fragt gerne nach, bevor er etwas verändert. Das ist gut für das Gesamtsystem aller Verknüpfungen, macht ihn aber auf Dauer wenig beliebt bei Kollegen. Der allgemeine Leistungsdruck schafft oft immer weniger Raum für Kollegialität. Also hört er irgendwann auf zu Fragen. Macht sich schlau und wird zum Typ 1, 2 oder 3.

Die fünf Grundtypen bilden den Krankheitsverlauf von Excelitis, die aber erst ihren Namen durch jene bekommen hat, die mit den Ergebnissen arbeiten – mitunter leben – müssen: Dem Management. Um erfolgskritische oder überhaupt Entscheidungen treffen zu können, bedarf es solider Informationen. Eine valide Datenbasis ist dafür die Grundvoraussetzung, denn bewertete Daten werden erst durch die Bewertung und sinnhafte Einordnung in einen Zusammenhang zu Informationen. Daher ist die Konsolidierung dieser Daten, fach- und sachgerecht über alle Bereiche des Unternehmens hinweg, erst das, was als Grundlage für Entscheidungen angesehen wird.

Der digitale Austausch dieser Daten hat die Globalisierung erst möglich gemacht. Sie steuerbar gemacht. Reports brauchten nicht mehr Wochen, um global verstreute Unternehmensteile postalisch zu erreichen. Zwischenkonsolidierte Reports sind fast überall, ad hoc abrufbar. Lediglich der Fluss dieser Informationen über Reportingsysteme ist eine Kunst geworden. Eine organisatorische und dann technische Herausforderung, der zu stellen sich die BI verpflichtet fühlt. Dazu bedarf sie valider Daten. Daten, auf deren Entstehung sie in aller Regel kaum Einfluss hat. Schon gar nicht auf deren Qualität. Dazu fehlt ihr oft auch die Fachkompetenz. Diese liegt bei den Mitarbeitern. Und da Excel die allererste Möglichkeit war, Daten miteinander zu verknüpfen, nicht-numerische Werte zu matchen und / oder sinnhaft mit anderen Werten logisch zu verbinden, ist diese Software omnipräsent. Und mit ihr die Usertypen. An letzteren hängt dann schlussendlich der Erfolg der endkonsolidierten und bewerteten Reportfassung als Entscheidungsgrundlage für das Topmanagement.

Bei SEPA war das Problem, wann wer welche Daten wo einspeist, die dann weiterverwendet wurden, um eine formal genau und gesetzlich definierte Prozessfolge auszulösen. Durch redundante Prozesse war das oft schwierig, überhaupt herauszufinden, wer die aktuellsten Daten besitzt, die für den Gesamtprozess notwendig waren. Zugehörige IT-Tools, Applikationen und Softwareergänzungen gab es reichlich. In der Regel funktionierten sie auch. Nur die Schnittstellenbefüllung mit validen Daten, gestaltete sich schwierig. Mitunter auch, weil unregelmäßig gepflegte Exceltabellen wesentlich zu dieser Befüllung beitrugen.

Daher sind BI-Tools auch so weit verbreitet. Sie formalisieren zum Teil die notwendigen Verknüpfungen; unter signifikanter Reduktion von fehlerhaften Usereingaben. Die notwendigen technischen Voraussetzungen, die nötige Rechenkapazität zur Reportgenerierung und die dazu nötigen ausgelagerten Speicherfunktionen werden gerade wieder durch die in-memory-Technik (z.B.: HANA von SAP) hinsichtlich hochverfügbarer Zugriffszeiten revolutioniert.

Warum ist das für Joint Future Work wichtig?

Für die Joint Future Work ist aber gerade diese valide Grunddatenmenge entscheidend. Und diese wird zu aller erst mit Reports hinsichtlich ihrer Relevanz für die zu stemmenden organisatorischen Herausforderungen ausgewertet. Und das schon im Vorprojekt [3]. Die BI wird im Wesentlichen dazu beitragen, beitragen müssen (!), für das Vorprojekt, die Planung und dann die begleitende Konzeption und Umsetzung der Maßnahmen (auch!) vergleichend mit noch nicht umgewandelten Organisationseinheiten zu berichten.

Dazu werden neue Reports erstellt werden müssen, die so noch nie angegangen worden sind. Zum Teil auch nur mit Zustimmung der Betriebsräte generiert werden dürfen, da es hier um Organisationsmaßnahmen geht, wo Mitarbeiterproduktivität ausgewertet und optimiert werden müssen. Also ein höchstsensibles Umfeld mit hochpolitischer Bedeutung im Unternehmen, wie auch gesellschaftlich. Gegebenenfalls sogar – und das ist stark anzunehmen – auch mit juristischer Relevanz. Daher müssen die für Entscheidungen relevanten Reports möglichst mit wenig Excelitis befallen sein. Valide sein. Denn nur so lassen sich glaubwürdige Ergebnisse kommunizieren und innerbetrieblich abzusehende Konflikte können minimiert werden.

Joint Future Work ist in seiner Dimension das größte Organisationsprojekt der ersten Hälfte dieses Jahrhunderts, das innerbetrieblich wie gesellschaftlich wirken wird und nicht mit seiner erstmaligen Realisierung abgeschlossen sein wird, sondern die wirtschaftliche wie auch gesellschaftliche Umgebung über Generationen prägen wird [4] [5]. BI-Systeme können hier technische Möglichkeiten bieten, die Organisation des Informationsflusses besser zu steuern und viele die Validität betreffende Fehlerquellen herausfiltern helfen. Das ist für das, was dann die Digitalisierung ausmachen wird von entscheidender Bedeutung. Doch letztlich wird es am Faktor Mensch liegen, der solche “Seuchen” wie Excelitis und damit die Entscheidungsgrundlagen maßgeblich (mit-)beeinflussen kann.

Joint Future Work ist ein Thema, das jeden Arbeitnehmer schon jetzt betrifft. Direkt und unmittelbar, denn auch er wird älter und muss länger arbeiten. Und da ist es in seinem Interesse, die alten Fehler auszumerzen, neue zu vermeiden und dafür zu sorgen, dass die Datenbasis so gut wie möglich wird. Das ist eine neue Chance für BI, neben den nun vorhandenen technischen Lösungen, auch die Userseite mitzugestalten. Psychologisch mitzugestalten. Denn niemals waren Belegschaften an sich auf diese Ergebnisse so angewiesen wie jetzt. Sie wissen es oft nur noch nicht… Und hier ist eine Chance der Einbindung der Mitarbeiter. Ihre Kompetenz, ihre Erfahrung und ihre informelle Strukturen mit einzubinden. Letzteres ist besonders wichtig, denn sie bilden eine nicht zu unterschätzende Schattenorganisation, die der neu zu schaffenden Arbeitswelt der Zukunft im Unternehmen zuwiderlaufen kann.

Joint Future Work heißt auch, die bisherigen Reportingstrukturen zu überdenken, damit suboptimale Workflows, Arbeitsweisen und Prozesse überhaupt erst entdeckt werden können. Die Grundvoraussetzung dafür, dass sie optimiert werden können, ist im Wesentlichen das Wissen um diese Potentiale. Informelle Strukturen werden in aller Regel aber nicht in ihrer Leistung, ihrer Ausprägung und ihrem Prozessanteil erfasst, ausgewertet oder beurteilt. Hier ist auch ein Ansatzpunkt, der den Erfolg oder auch Misserfolg der Digitalisierung ausmacht. Hier trennt sich dann die Vision der Denker von der Realität der Macher.

Dies passiert nur mit den formal erfassten Prozessen. Wenn diese aber im Ergebnis schon ungenau reportet werden, weil mit ausgeprägter Excelitis behaftet, kommt ein Aspekt ins Spiel, der gerne totgeschwiegen wird. Totgeschwiegen deshalb, weil die Behebung langwierig ist und damit Ressourcen kostenverursachend bindet. Zum Beispiel versuchte ein Software-Unternehmen einmal, alle Reports zu erfassen, die im Unternehmen von wem, wo und für wen auf welchem Wege verfasst, (nicht) gebraucht, nachgefragt oder bereitgestellt wurden. Dazu sandte es eine Exceltabelle herum, die in Spalten exakt das abfragte. Unkommentiert. Ohne Definitionen. Als reine Ausfüllaufgabe. Das Ergebnis war vorhersehbar: Es gab mehrere hundert Reports. Leider ließ sich das nicht auswerten, denn selbst gleiche Reports wurden in unterschiedlichen Abteilungen unterschiedlich benannt. Aber es wurde auch deutlich, dass wesentlich mehr berichtet und bereitgestellt wurde als gedacht. Und dass das, was bereitgestellt wurde, auch von Leuten für eigene Berichte genutzt wurde, von denen man nichts wusste. Und dass diese dann mit den von ihnen verfassten, eigenen Reports exakt auf die Abteilungen Einfluss nahmen, die eben diese Zahlen unwissentlich bereitgestellt hatten. Ohne eine laufende valide Aktualisierung und hinterlegte Fachlichkeit. Ohne klare Verantwortlichkeit und zum Teil auf Basis von “good will”.

Das Beispiel zeigt die Excelitis in höchster Vollendung. Einer Herausforderung, die im Vorprojekt für das Planungsprojekt anzugehen ist, damit Future Work und die Anpassungen der Future Workforce gelingt. Oder die Digitalisierung gelingen kann. Denn wer nicht weiß, wie der Prozess aussieht, wird nicht die IT-Schnittstellen optimieren können, die wesentlich sind. Erfolgskritisch… Natürlich wird es gelingen. Man kann in der IT alles machen. Nichts ist unmöglich. Man braucht nur zwei Dinge: Zeit und Geld!

Es ist Herausforderung wie auch Chance. Eine Chance, alle Mitarbeiter einzubinden, dabei zu helfen ihre Leistung für eine Future Workforce durch bessere oder gar erstmalige Visualisierung machbarer zu machen. Und für jeden persönlich dann vielleicht auch wertgeschätzter. Ein Aspekt, der psychologisch nicht hoch genug zu bewerten ist. Für die Digitalisierung heißt das, dass sie die Arbeit im Alter machbar machen kann [6]. Sie unterstützt den demographischen Wandel in den Unternehmen. Hilft Fachexpertise im Unternehmen zu halten. Eine Expertise, die nicht nur wesentlich für die organisatorischen Schnittstellen ist, sondern auch für die IT an sich, die nun die Digitalisierung umsetzen muss. Und da gibt es in der Hard- und Softwarearchitektur mit Sicherheit Programme, Schnittstellen und “Übergangslösungen”, die so nirgends mehr gelehrt werden. Aus Zeiten, wo IT noch EDV hieß. Auch ein Aspekt, der zu überdenken wäre. Neben der Tatsache, dass in der IT schon sehr bald massive Stellenbesetzungslücken auftreten werden [7].

Die valide Datenbasis ist in ihrer digitalen Verknüpfung für all die Faktoren und Berührungspunkte, was wir dann als Digitalisierung bezeichnen (wollen / müssen), entscheidend. Und Excelitis ist nur die bekannteste Fehlerquelle im Rahmen dessen, was dann mal Big Data heißen soll.

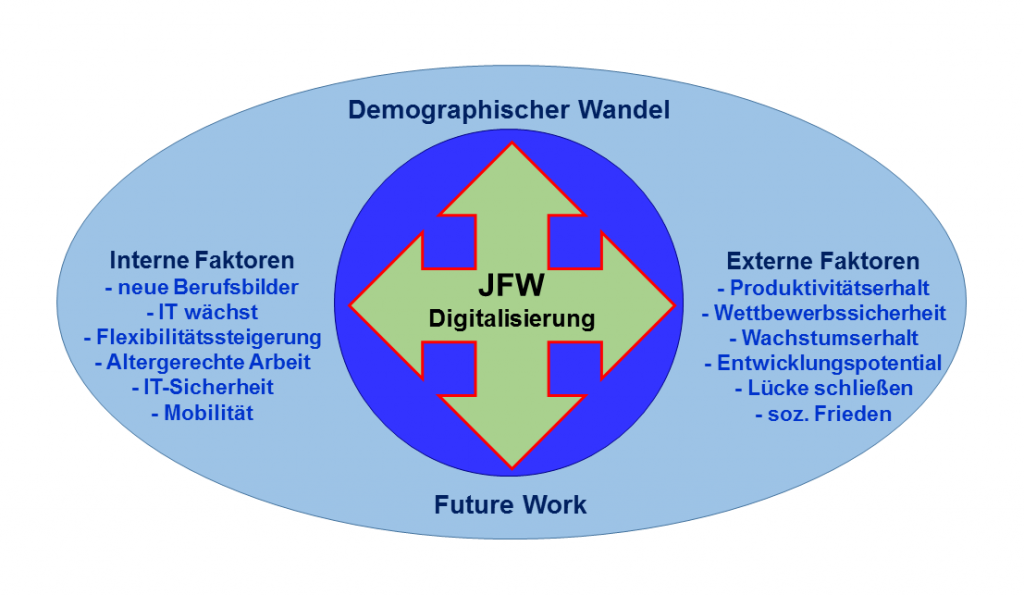

Abb.: Zusammenhang von Joint Future Work und Digitalisierung im demographischen Wandel

FAZIT:

Der Business Intelligence kommt über die zu gestaltenden Reportingsysteme ein nachhaltiger Gestaltungsansatz für die Future Work zu. Sie verifiziert oder falsifiziert monetären Wert, Sinnhaftigkeit, Ausprägung und Werthaltigkeit von ganzen interagierenden Prozessketten und den in ihr (zusammen)arbeitenden Menschen. Diese Leistungsprozesse korrekt abzubilden, ist die allererste Aufgabe im Umfeld eines jeden Future Work Projektes. Sie sind die Basis einer jeden weiterführenden Überlegung.

Im weiteren Verlauf sind die Reports entscheidend dafür, wie die “gefühlte Validität” die Kommunikation zwischen allen Beteiligten beeinflusst. Jeder Beteiligte bis hinunter zum einfachen Lagerarbeiter wird um die Bedeutung der Ergebnisse wissen, die Einfluss auf seine Beschäftigung im Alter haben werden. Daher werden die Beschäftigten und mit ihnen ihre Arbeitnehmervertreter extrem argwöhnisch sein, wenn es um die Bewertung des Status Quo geht. Zumal jeder um die (möglichen) Fehler in der Datenbasis weiß, auf der aufbauend etwas entstehen soll, was nachhaltig die Unternehmen verändern wird. Daher wird die BI folgerichtig ein entscheidendes – gesamtheitlich zu sehendes – Kriterium zur Future Work beisteuern: die Offenheit, die Visualisierung und die Sichtbarkeit an sich. Letztere ist entscheidend für eine zielgerichtete Kommunikation und Information aller Beteiligten.

Wenn bisher schon die Bedeutung der Business Intelligence stark zugenommen hat, dann wird die Bedeutung der BI, gerade in Unternehmen mit Excel-Berichtskonstrukten, eher noch zunehmen. Als nicht nur ein Instrument, das das Berichtswesen zeitlich, organisatorisch und inhaltlich steuert, sondern auch als ein Instrument, das hilft neue Strukturen zu schaffen, diese hinsichtlich ihrer Wirksamkeit schon in der Entstehungsphase begleitet und später dann fortlaufend gegen die gewünschte Zielerreichung trackt.

Letztlich geht es darum, auch im Reporting das abzubilden, was Future Work und mit ihr die Digitalisierung eigentlich ausmachen wird: nicht einfach “nur” anders zu arbeiten, sondern flexibler auf demographische determinierte Prozessänderungen und -erfordernisse eingehen zu können [8]. Die rechtzeitige Erfassung solcher KPIs, und deren Definition und Implementierung, wird eine weitere Herausforderung sein, die das BI im HRM-Bereich zu meistern haben wird.

Es wird nicht mehr reichen Top-Down-Ansätze umzusetzen, wenn es darum geht, auch die informellen Strukturen im Informationsfluss zu erfassen. Schon gar nicht, wenn es um die sichtbar zu machende Produktivität von Mitarbeitern und Organisationseinheiten geht. Doch um auch informelle Strukturen mit erfassen zu können, bedarf es des Vertrauens. Ein Vertrauen, das erst erarbeitet werden muss. Am besten durch glaubhaftes, offenes und proaktives Herangehen an die, die Joint Future Work gestalten müssen. Es leben müssen: die Mitarbeiter. Den Menschen an sich. Es wäre ein Irrglaube, gerade hier im DACH-Raum, Future Work, demographischen Wandel und Digitalisierung trennen zu können. Das Eine bedingt das Andere. Untrennbar. Und das in mehreren Phasen [9].

Die Digitalisierung ist ein Werkzeug, nicht nur um die internationale Konkurrenzfähigkeit zu gewährleisten, sondern auch ein Instrument, das Arbeit im Alter zum Teil erst ermöglicht. In der Umsetzung bedarf sie allerdings der Mithilfe derer, die die Daten und Informationen dazu generieren, konsolidieren, bereitstellen und zyklisch mit ihnen arbeiten, damit andere aus ihnen entscheidungsrelevante Führungsaufgaben wahrnehmen können. Zum Beispiel auch Entscheidungen hinsichtlich des (auch real machbaren!) Digitalisierungsniveaus treffen zu können [10].

Quellen:

[1] Future Business Consulting: Definition Joint Future Work (2014): “Definition Joint Future Work”

[2] Rauschenberger, Sascha (2013 / 2014): “SEPA: das unterschätze Projekt (Teil 1): Überblick” und “(Teil 2): Ein Erfolg, sieben Baustellen und ‘ein schlechter Witz’” (Conplore Magazine)

[3] Future Business Consulting (2014): “Umsetzungsplan Future Workforce : 12 Schritte in die Arbeitswelt der Zukunft – Steps 1 bis 5: Die erfolgskritische Vorbereitung des Projektes”

[4] Rauschenberger, Sascha (2014): “Future Work ist Organisationsentwicklung – mit Hindernissen” (Conplore Magazine)

[5] Rauschenberger, Sascha (2015): “Joint Future Work – Ein strategisches Gesamtkonzept für Gesellschaft, Wirtschaft und Politik im demographischen Wandel” (Future Business Consulting)

[6] Rauschenberger, Sascha (2014): “Demografischer Wandel und Future Work: Eine gesellschaftliche Herausforderung für den Arbeitsmarkt der Zukunft” (Conplore Magazine)

[7] Rauschenberger, Sascha (2015): “Future Work und IT-Personalkosten: “Die Lösung liegt in konsequenter Beschränkung auf das Wesentliche” (Conplore Magazine)

[8] Future Business Consulting (2014): “HRM und Arbeitsflexibilisierung: Chance und Risiko für Future Work”

[9] Rauschenberger, Sascha (2015): “Joint Future Work – Ein Tsunami verändert die Arbeitswelt der Zukunft” (Conplore Magazine)

[10] Rauschenberger, Sascha (2015): “Joint Future Work und Digitalisierung: Chance für den demographischen Wandel – Gedanken zur Umsetzung” (Conplore Magazine)